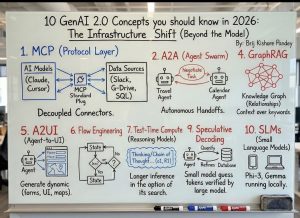

Dans la lignée des travaux de Brij Kishore Pandey

En 2023 et 2024, le débat sur l’intelligence artificielle générative s’est cristallisé autour d’un objet central : le modèle. Taille des paramètres, performances sur les benchmarks, capacité à produire du texte, du code ou des images. Cette focalisation a eu un effet pervers : elle a masqué une transformation plus profonde, plus structurelle, et sans doute plus durable.

En 2026, l’enjeu n’est plus tant ce que sait faire un modèle que dans quel système il opère. Nous entrons dans une phase que l’on peut qualifier de GenAI 2.0, marquée par un déplacement du centre de gravité : des modèles vers l’infrastructure, des prompts vers les protocoles, des réponses isolées vers des chaînes d’action distribuées.

Ce changement est moins spectaculaire que les démonstrations de génération de texte. Il est pourtant décisif pour les entreprises.

Du modèle au système : une rupture conceptuelle

La première génération d’IA générative reposait sur une interaction simple : un humain formule une requête, un modèle répond. Cette logique, héritée des moteurs de recherche, reste fondamentalement réactive. Elle limite l’IA à un rôle d’assistant conversationnel, aussi performant soit-il.

GenAI 2.0 rompt avec cette approche. L’IA devient un composant d’un système distribué, capable d’orchestrer des données, de coopérer avec d’autres agents, d’agir sur des environnements numériques et de maintenir un état dans le temps. L’intelligence n’est plus contenue dans un seul modèle, mais émerge de l’architecture globale.

Ce déplacement oblige à repenser la gouvernance, la responsabilité et la valeur créée.

- MCP : la couche protocolaire comme nouveau socle

Le Model Context Protocol (MCP) incarne ce basculement. Il ne s’agit pas d’un modèle supplémentaire, mais d’une couche d’interopérabilité standardisée entre modèles et sources de données.

Concrètement, MCP permet de connecter un modèle à des environnements hétérogènes – bases SQL, documents, outils collaboratifs, applications métier – sans dépendance forte à une implémentation spécifique. Le modèle cesse d’être un point d’entrée unique. Il devient un acteur interchangeable dans un écosystème.

Pour les entreprises, l’enjeu est stratégique : réduction du verrouillage fournisseur, meilleure traçabilité des accès aux données, séparation claire entre raisonnement et exécution.

La valeur ne réside plus dans la sophistication du modèle, mais dans la maîtrise des flux qu’il traverse.

- A2A : quand les agents négocient entre eux

Le paradigme Agent-to-Agent (A2A) introduit une rupture plus radicale encore. Les agents ne se contentent plus d’exécuter des ordres humains. Ils négocient, se coordonnent et se transmettent des tâches de manière autonome.

Un agent spécialisé dans le voyage peut dialoguer avec un agent de calendrier, arbitrer des contraintes, proposer des compromis. L’humain n’intervient plus à chaque étape. Il définit un objectif et des règles. Cette logique soulève une question centrale : À partir de quel moment l’autonomie fonctionnelle devient-elle un problème de gouvernance ?

Dans les organisations, la tentation sera forte d’automatiser des chaînes entières de décision. Or, plus la délégation est distribuée, plus la responsabilité devient diffuse.

- GraphRAG : du mot-clé au sens structuré

Le GraphRAG marque une évolution silencieuse mais déterminante du RAG classique. Là où le RAG indexe des documents, GraphRAG structure des relations : entités, dépendances, hiérarchies, causalités.

L’IA ne recherche plus seulement des passages pertinents. Elle raisonne sur un graphe de connaissances. Le contexte ne se réduit plus à une fenêtre de tokens ; il devient une représentation du réel.

Pour les entreprises, cela change la nature même de l’IA décisionnelle. Elle peut : relier des événements distants, expliciter des liens implicites, réduire certaines hallucinations structurelles. Mais cette promesse repose sur une condition : la qualité ontologique du graphe. Mal conçu, il rigidifie la pensée au lieu de l’éclairer.

- A2UI : l’interface comme produit de l’agent

Avec Agent-to-UI (A2UI), l’IA ne se contente plus de produire du texte. Elle génère des interfaces dynamiques : formulaires, cartes, tableaux, visualisations.

L’interface cesse d’être un artefact figé conçu en amont. Elle devient contextuelle, adaptative, temporaire. L’agent crée l’outil dont il a besoin pour accomplir la tâche.

Cette évolution remet en question les frontières classiques entre produit, UX et logique métier. Elle pose aussi un problème de contrôle : qui valide une interface générée à la volée ? Selon quels standards ?

- Flow Engineering : orchestrer des états, pas des prompts

Le Flow Engineering remplace progressivement le prompt engineering. L’enjeu n’est plus de formuler la bonne instruction, mais de gérer des états successifs, des bifurcations, des conditions. L’IA devient un processus. Elle conserve une mémoire opérationnelle, teste des hypothèses, revient en arrière, ajuste ses décisions.

Pour les dirigeants, cela implique un changement de posture : piloter une IA revient moins à la “questionner” qu’à designer un système de décision.

- Test-Time Compute : le temps de calcul comme variable stratégique

Avec le Test-Time Compute, le raisonnement n’est plus figé à l’entraînement. Le modèle peut allouer plus de calcul au moment de l’inférence pour explorer plusieurs pistes. Cette capacité améliore la qualité des réponses sur des problèmes complexes. Mais elle introduit un arbitrage nouveau : précision versus coût, profondeur versus latence. L’intelligence devient une ressource modulable, et non un attribut constant.

- Speculative Decoding : la coopération asymétrique

Le Speculative Decoding repose sur une idée simple : un petit modèle propose, un grand modèle vérifie. Cette coopération réduit les coûts et accélère l’inférence. Elle illustre une tendance plus large : l’intelligence n’est plus monolithique. Elle est hiérarchisée, distribuée, spécialisée. Cela ouvre la voie à des architectures hybrides, combinant modèles locaux, cloud et edge computing.

- SLMs : le retour du local et du frugal

Les Small Language Models (SLMs) signent le retour du calcul local. Moins puissants, mais plus contrôlables, ils répondent à des contraintes de souveraineté, de latence et de confidentialité. Leur intérêt n’est pas de rivaliser avec les grands modèles, mais de s’insérer intelligemment dans un système multi-niveaux.

Ce que GenAI 2.0 change réellement pour les entreprises

Le message clé est clair : l’avantage compétitif ne viendra pas du modèle le plus performant, mais de l’architecture la mieux pensée. Les entreprises qui réussiront seront celles qui sauront : structurer leurs données avant de les exposer, définir des règles de délégation explicites, intégrer l’IA dans leurs processus réels, maintenir une gouvernance humaine claire.

La question n’est plus “Que peut faire l’IA ?”, mais “À quoi lui déléguerons-nous le droit d’agir ?”