À Cannes, lors du WAICF, Yann LeCun ne commente pas l’actualité de l’intelligence artificielle générative. Il déroule une architecture. Une trajectoire scientifique construite depuis plusieurs années et qu’il présente comme la seule voie crédible vers une intelligence de niveau humain. Le propos est calme, méthodique, presque pédagogique. La conclusion, elle, est sans ambiguïté : les grands modèles de langage ne constituent pas la bonne direction si l’objectif est de bâtir des systèmes capables de comprendre et d’agir dans le monde réel.

À Cannes, lors du WAICF, Yann LeCun ne commente pas l’actualité de l’intelligence artificielle générative. Il déroule une architecture. Une trajectoire scientifique construite depuis plusieurs années et qu’il présente comme la seule voie crédible vers une intelligence de niveau humain. Le propos est calme, méthodique, presque pédagogique. La conclusion, elle, est sans ambiguïté : les grands modèles de langage ne constituent pas la bonne direction si l’objectif est de bâtir des systèmes capables de comprendre et d’agir dans le monde réel.

Au centre de l’intervention se trouve l’AMI — l’Autonomous Machine Intelligence — et, au-delà, la stratégie industrielle d’AMI Lab.

Le point de départ est une distinction fondamentale entre générer et comprendre. Les modèles autorégressifs, qu’ils soient textuels, visuels ou multimodaux, produisent des séquences. Ils prédisent le prochain mot, le prochain pixel, la prochaine valeur. Ils atteignent un niveau remarquable de cohérence statistique, mais cette cohérence ne constitue pas une compréhension des dynamiques physiques. Prédire une suite n’est pas modéliser un système.

Cette limite apparaît dès que l’on quitte les données propres et discrètes pour entrer dans le monde réel, fait de signaux continus, bruités, partiellement observables. Yann LeCun prend l’exemple d’un moteur d’avion moderne, équipé de plus d’un millier de capteurs. Température, pression, vibration, flux. Dans un tel environnement, la simple prédiction de séries temporelles — autrement dit une approche générative — ne permet pas d’optimiser le fonctionnement global. Elle ne permet pas de planifier des interventions pour maximiser la fiabilité, réduire les émissions de CO₂ ou améliorer les performances. Ce qu’il faut, explique-t-il, c’est un modèle phénoménologique global capable d’anticiper la dynamique du système dans son ensemble.

La cible initiale d’AMI Lab se situe précisément là : les systèmes industriels complexes. Centrales électriques, aciéries, usines chimiques, moteurs aéronautiques, où les flux de données sont massifs, continus et bruités, et où la valeur provient de la capacité à planifier sous contrainte physique. Le marché des agents conversationnels est déjà saturé ; celui des systèmes prédictifs pour le monde réel ne l’est pas. L’ambition est progressive : accumuler de l’expérience en appliquant ces architectures à des modalités de données de plus en plus diverses, avant d’atteindre, à terme, la robotique. Le marché des robots intelligents n’est pas encore mature, mais il le deviendra. AMI Lab veut être prêt au moment de cette bascule.

Le socle scientifique de cette stratégie repose sur JEPA — Joint Embedding Predictive Architecture. Le principe consiste à ne plus reconstruire les données dans leur forme brute, mais à prédire la représentation abstraite d’une partie manquante à partir de son contexte. Le travail se fait dans l’espace latent, où se trouvent les invariants pertinents, et non dans l’espace des pixels ou des valeurs numériques, saturé de bruit et de variations sans importance.

Avec Image-JEPA, l’apprentissage autosupervisé par masquage permet d’obtenir des représentations robustes avec un coût de calcul réduit. La logique est ensuite étendue à la vidéo avec V-JEPA. Il ne s’agit plus de prédire l’image suivante, mais la représentation du futur. Cette nuance est essentielle : elle permet de se concentrer sur la dynamique structurelle d’une scène et d’ignorer les détails imprévisibles.

C’est dans ce cadre qu’apparaît ce que Yann LeCun qualifie de forme de « physique intuitive ». Les modèles apprennent à anticiper l’évolution plausible d’une situation. Lorsque la séquence observée viole cette cohérence — une trajectoire impossible, une interaction physiquement incohérente, l’écart entre la représentation prédite et l’observation réelle augmente. Il ne s’agit pas d’un raisonnement symbolique, mais d’une cohérence dynamique acquise par l’apprentissage.

V-JEPA 2 introduit ensuite l’apprentissage à grande échelle à partir de vidéos naturelles et, surtout, le conditionnement par l’action. Comprendre la dynamique du monde ne suffit pas ; il faut apprendre comment les actions la modifient. On ne cherche plus à générer des images réalistes, mais à construire un modèle interne capable d’anticiper les conséquences d’une décision.

Le LA-WM — le modèle du monde à actions latentes — franchit une étape supplémentaire. Dans les environnements réels, toutes les actions ne sont pas observées. Le modèle doit inférer des variables latentes représentant les dynamiques sous-jacentes. L’encodeur issu de V-JEPA est figé ; au-dessus, un modèle apprend les transitions. L’information est volontairement régularisée — ajout de bruit, sparsification, quantification — pour éviter les raccourcis statistiques. L’objectif est de construire une représentation stable et exploitable pour la planification.

Cette question de la stabilité des représentations conduit à SIGReg, une méthode de régularisation isotrope gaussienne destinée à préserver la richesse informationnelle de l’espace latent. L’apprentissage autosupervisé souffre souvent d’un effondrement des embeddings ; imposer une distribution isotrope maintient la diversité des représentations tout en stabilisant l’entraînement.

L’ensemble forme une architecture cohérente orientée vers la planification. Dans ce cadre, l’apprentissage par renforcement n’est plus la méthode centrale. Il n’intervient que lorsque la planification échoue, pour ajuster le modèle du monde ou le critique. La logique est celle du contrôle prédictif fondé sur un modèle interne — une approche directement issue de l’ingénierie des systèmes.

La distinction entre Système 1 et Système 2 est évoquée dans la discussion. Le Système 1 correspond à l’intuition rapide, prédictive, construite à partir d’un modèle interne du monde. Le Système 2 — le raisonnement délibératif — ne peut émerger que sur cette base. L’intelligence n’est donc pas d’abord linguistique ; elle est sensorimotrice et prédictive.

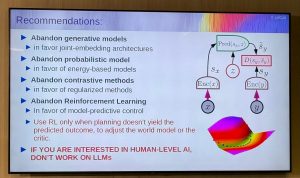

La slide finale synthétise la position de manière particulièrement explicite.

- Abandonner les modèles génératifs au profit d’architectures à embeddings conjoints.

- Abandonner les modèles probabilistes au profit de modèles fondés sur l’énergie. Abandonner les méthodes contrastives au profit de méthodes régularisées.

- Abandonner l’apprentissage par renforcement comme paradigme central au profit de la planification fondée sur un modèle interne.

Et cette conclusion, volontairement provocatrice : si l’on vise une intelligence de niveau humain, il ne faut pas travailler sur les grands modèles de langage.

Dans un écosystème dominé par l’IA générative, cette intervention trace une trajectoire radicalement différente. Là où la compétition actuelle porte sur l’augmentation de la taille des modèles et la fluidité conversationnelle, Yann LeCun met l’accent sur la construction de modèles du monde capables d’anticiper, de planifier et d’agir.

L’enjeu n’est pas seulement scientifique. Il est industriel. Optimiser des systèmes physiques complexes aujourd’hui. Construire les cerveaux des robots demain.

Une intelligence qui ne se contente pas de produire du texte plausible, mais qui sait intervenir dans le réel.